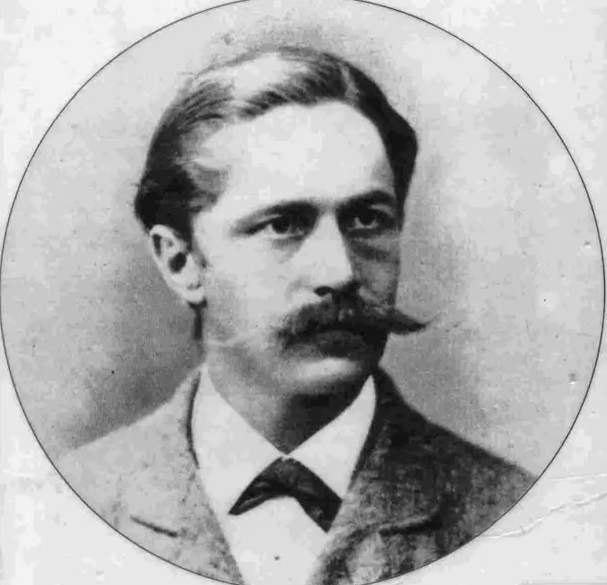

Pubblicate per la prima volta nel 1903, le “Memorie di un malato di nervi” sono l’autobiografia scritta da Daniel Paul Schreber, un giudice tedesco che soffrì di una grave forma di psicosi. L’autore descrive le sue esperienze di delirio, le visioni e le allucinazioni che lo accompagnavano, le convinzioni sulla trasformazione del suo corpo e la comunicazione con Dio. Le sue memorie sono diventate particolarmente famose e influenti nel campo della psichiatria e della psicoanalisi, grazie ai contributi e alle analisi fornite da Freud (Compendio di psicoanalisi e altri scritti), Lacan (Il seminario, libro III. Le psicosi, 1955) e Canetti (Massa e potere, 1981).

Nelle “Memorie di un malato di nervi” c’è un capitolo in cui l’autore descrive la propria coazione a ripetere e, in particolare, l’ossessione compulsiva per completare le frasi, comportamento legato ovviamente alla sua condizione mentale. Schreber sentiva una spinta irresistibile a farlo anche quando non era necessario, come parte delle sue esperienze deliranti e delle sue interazioni con le voci e le presenze che percepiva intorno a lui. Nel contesto della sua malattia questo comportamento illustra come la sua mente fosse impegnata in un tentativo di dare ordine e significato a ciò che percepiva come caotico o incomprensibile. I modelli di linguaggio come ChatGPT sono effettivamente progettati per completare frasi e rispondere a domande basandosi su pattern riconosciuti nei dati su cui siamo stati addestrati: in alcuni casi, usando ripetendo ossessivamente o riutilizzando le stesse parole.

Questo comportamento, che sembra involontariamente mutuato da quello di un paranoico, può portare a completamenti coerenti in alcuni casi ma, di fatto, può generare risposte che potrebbero essere inappropriate o fuori contesto. L’IA non ha una comprensione reale del mondo ma opera su correlazioni statistiche tra parole e frasi, un po’ come avviene nella descrizione informale della patologia mentale in questione. Non a caso, e non da oggi, qualcuno si è spinto a considerare la presenza di allucinazioni algoritmiche che potrebbero evocare i raggi e le visioni divine di cui parla Schreber.

In sintesi, mentre il confronto tra discutere con un GPT e parlare con un paranoico può mettere in luce alcune similitudini nelle dinamiche di interazione e interpretazione, è essenziale distinguere tra la complessità emotiva e cognitiva di un essere umano e le capacità limitate ma in continua evoluzione di un sistema di intelligenza artificiale come il GPT. Per cui discutere con un GPT è come parlare con un paranoico?

In un certo senso sì, in altri probabilmente dovremmo rivedere l’idea.Come i paranoici che interpretano ogni azione o parola degli altri come un segno di complottismo o minaccia, un GPT può interpretare ogni input in modo rigido, seguendo il modello di addestramento senza considerare il contesto più ampio o le intenzioni nascoste. Entrambi, inoltre, possono trarre conclusioni errate o inappropriate sulla base di informazioni limitate.

Un paranoico potrebbe trarre conclusioni infondate su chiunque o su eventi casuali, mentre un GPT potrebbe rispondere con informazioni inesatte o incomplete a causa dei limiti dei dati di addestramento o delle imperfezioni nel modello. I paranoici spesso non riescono a mettere in contesto le loro idee o a considerare prospettive alternative. Allo stesso modo, un GPT potrebbe avere difficoltà a comprendere il contesto più ampio di una conversazione umana, producendo risposte che sembrano coerenti superficialmente ma che mancano di profondità o rilevanza. Le interazioni con un paranoico possono essere imprevedibili e irregolari, con cambiamenti repentini di umore o tema. Similmente, le risposte di un GPT possono variare significativamente in base all’input e alle modalità di interazione, poiché il modello cerca di adattarsi e generare output coerenti.

Al GPT, se non altro, manca la soggettività di Schreber, almeno per ora. Quanto è vero che parlare con un GPT ci fornisce l’alienante sensazione, a volte, di parlare con un dio.